PR CENTER

PR센터

![]()

![]() PR센터

PR센터![]() 보도자료

보도자료

보도자료

| [GIGABYTE] AI에 적합한 서버를 선택하는 방법은 무엇입니까? 1부: CPU 및 GPU | |

|---|---|

| 작성자 : 관리자( khkim@goak.co.kr) 작성일 : 2023.09.25 조회수 : 349 | |

| 첨부파일 |

o202309111708136061.jpg |

생성적 AI와 기타 인공 지능의 실용적인 응용이 등장하면서 "AI 서버"의 조달은 자동차부터 의료까지 다양한 산업, 학계 및 공공 기관 모두에서 우선 순위가 되었습니다. GIGABYTE Technology의 최신 기술 가이드에서는 가장 중요한 두 가지 구성 요소인 CPU와 GPU부터 시작하여 AI 서버의 8가지 주요 구성 요소를 단계별로 안내합니다. 올바른 프로세서를 선택하면 슈퍼컴퓨팅 플랫폼을 활성화하고 AI 관련 컴퓨팅 워크로드를 가속화할 수 있습니다.

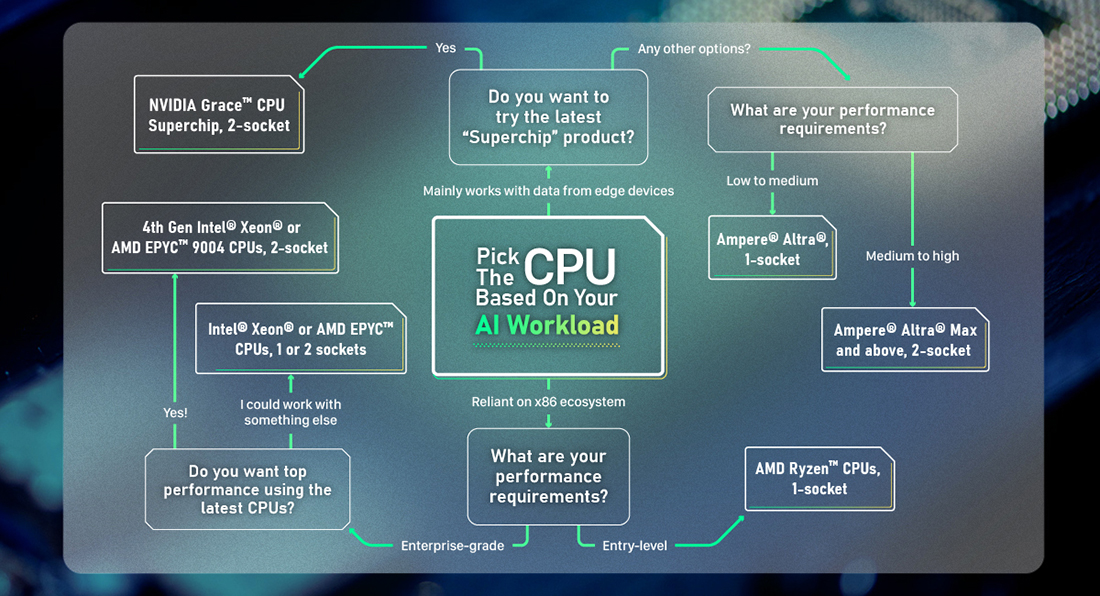

AI 서버에 적합한 CPU를 선택하는 방법은 무엇입니까?

완전하지는 않지만 이 순서도는 AI 워크로드에 가장 적합한 CPU 설정에 대한 좋은 아이디어를 제공합니다.

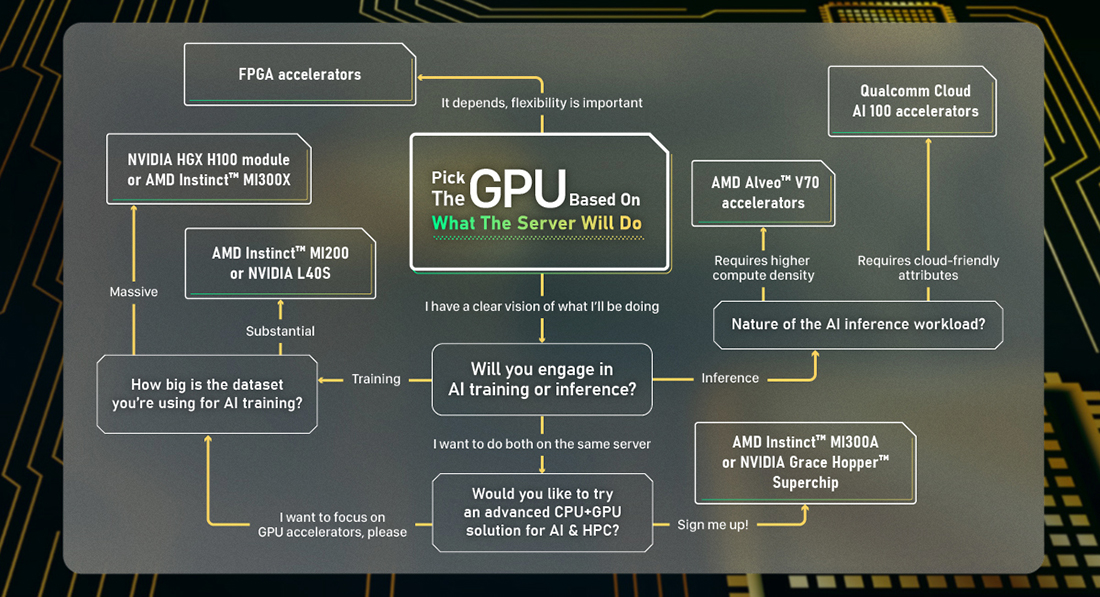

AI 서버에 적합한 GPU를 선택하는 방법은 무엇입니까?

GPU는 AI 워크로드 처리의 핵심이므로 실제 요구 사항에 따라 올바른 옵션을 선택하는 것이 중요합니다.

|

|

| 이전글 | [GIGABYTE] 지리적 경계를 뛰어넘다! BIM 기술 혁신 센터 |

| 다음글 | [GIGABYTE] 인공 지능에 관해 자주 묻는 10가지 질문 |