PR CENTER

PR센터

![]()

![]() PR센터

PR센터![]() 보도자료

보도자료

보도자료

| [GIGABYTE] GIGABYTE 서버를 통한 SupremeRAID™ BeeGFS™ 성능 | |

|---|---|

| 작성자 : 관리자( khkim@goak.co.kr) 작성일 : 2024.03.05 조회수 : 314 | |

| 첨부파일 |

giga 보도.JPG |

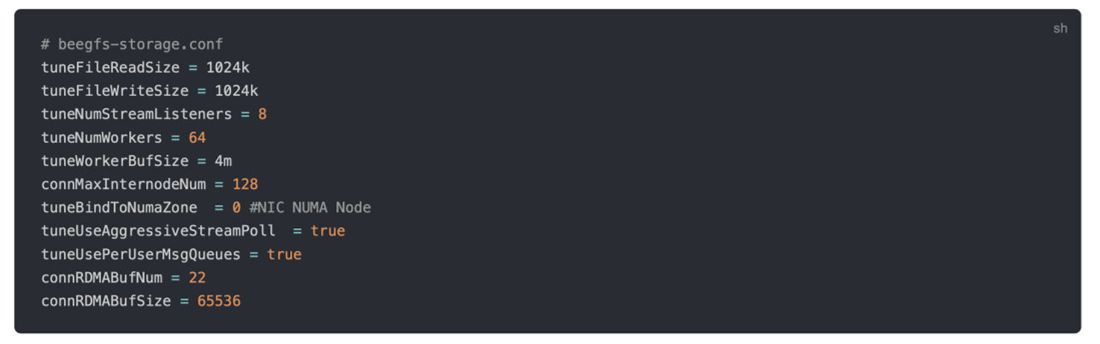

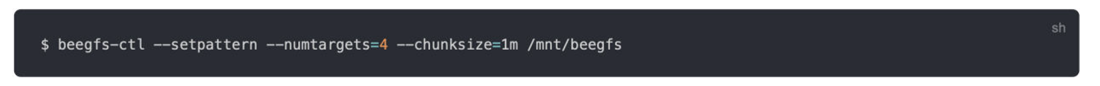

백서에서는 GIGABYTE S183-SH0을 탑재한 SupremeRAID™가 밀도가 매우 높고 효율적인 병렬 파일 시스템 솔루션을 생성하고 BeeGFS의 성능을 향상시켜 고성능 컴퓨팅 및 인공 지능 애플리케이션에 이상적으로 만드는 방법을 살펴봅니다.

요약

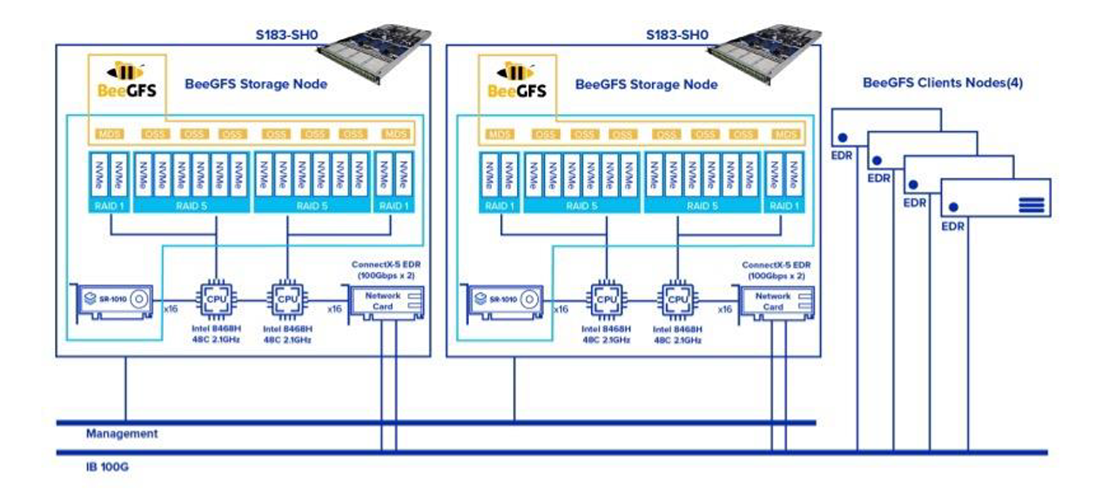

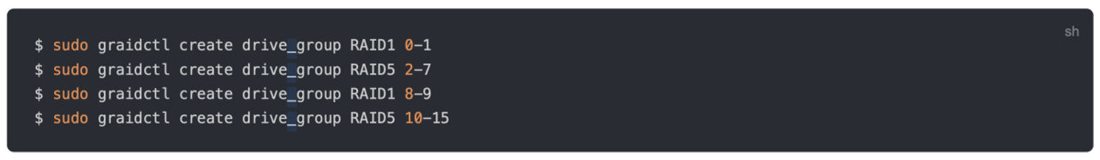

1. 4개의 RAID 5 그룹으로 구성된 12개의 7GB/s SSD로 구성된 2세트. 2. 총 400G에 대한 4개의 100G 이더넷 링크.

테스트 배경

클러스터 아키텍처

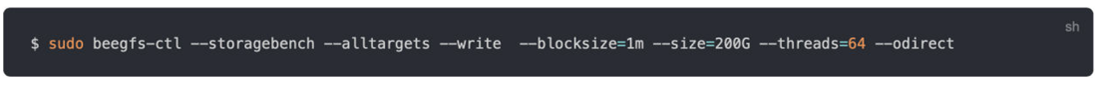

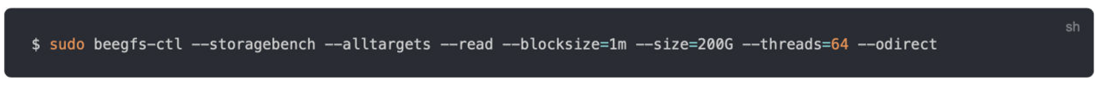

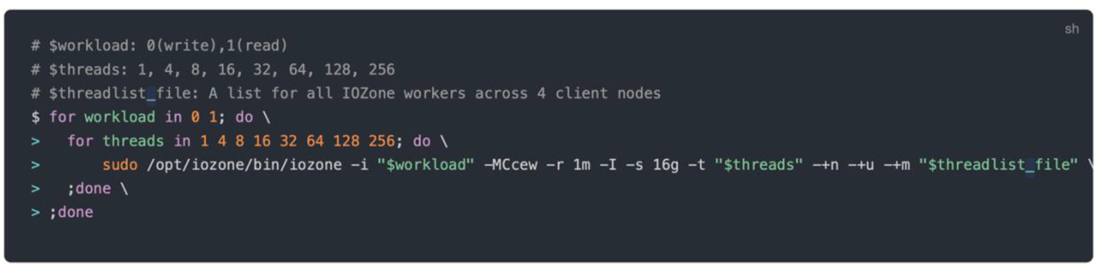

프로필 테스트

테스트 결과

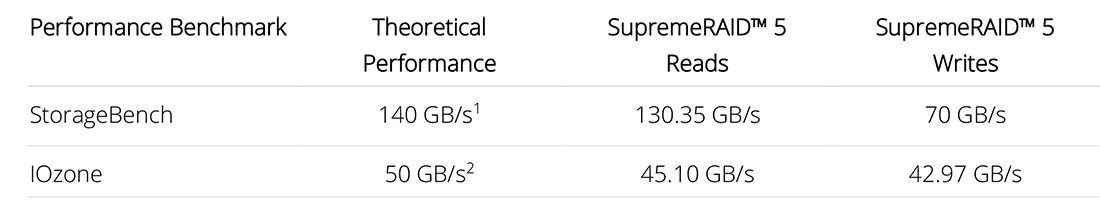

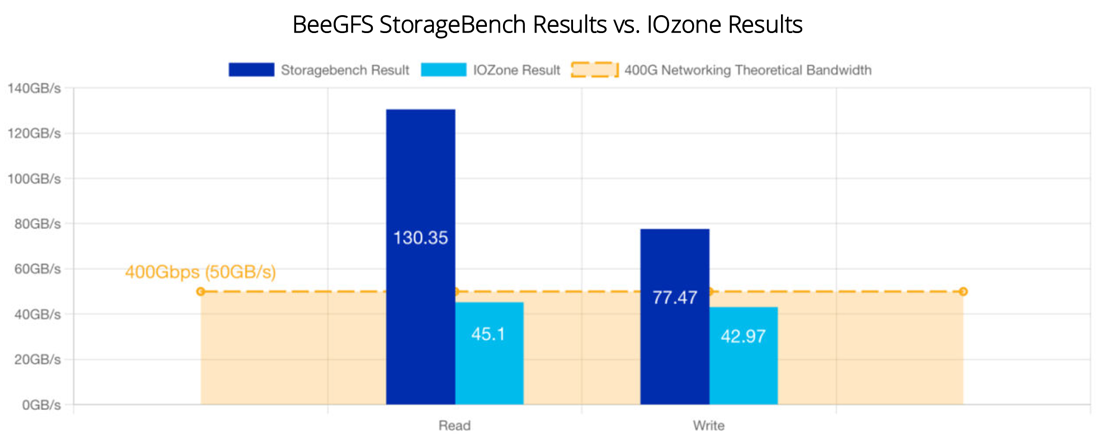

BeeGFS StorageBench 결과와 IOzone 결과 비교

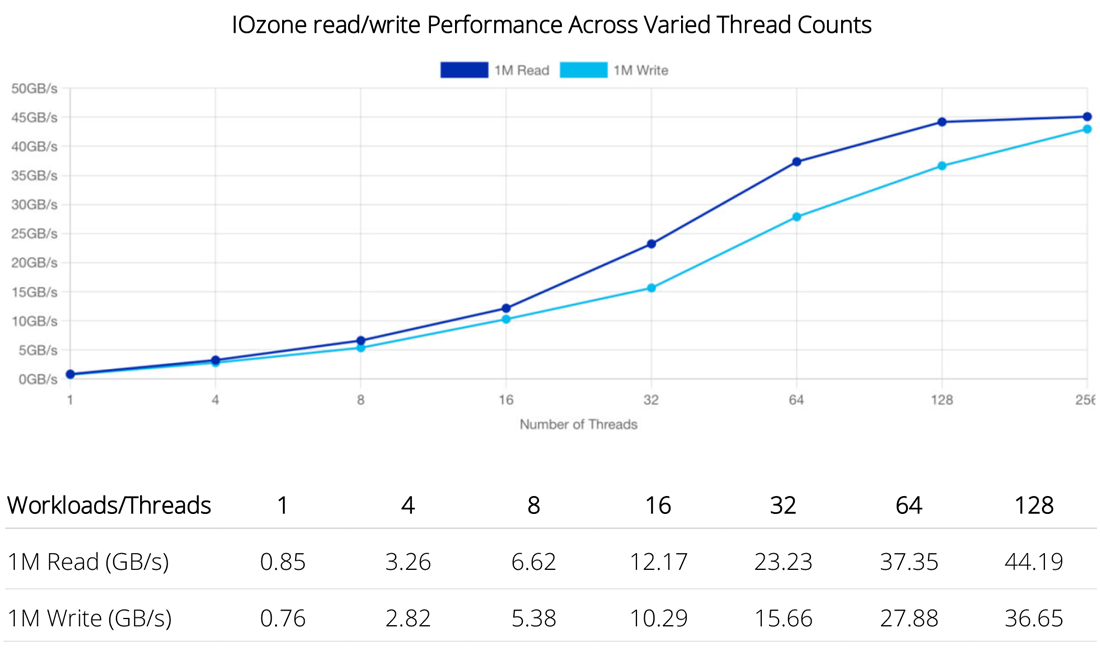

다양한 스레드 수에 따른 IOzone 읽기/쓰기 성능

요약

결론

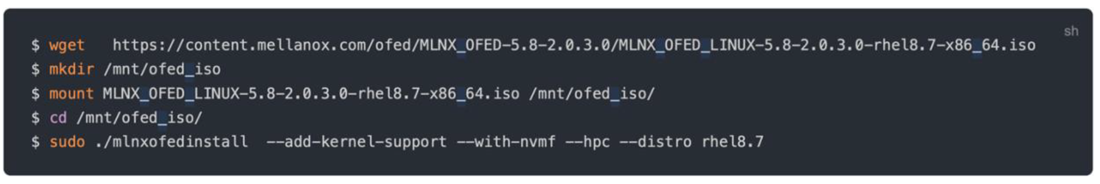

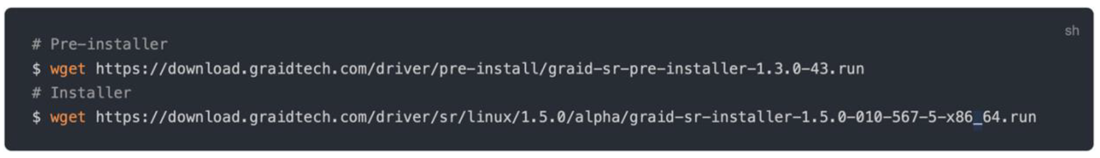

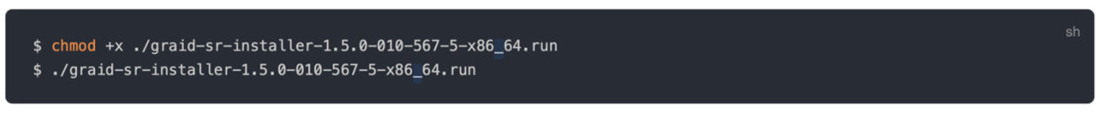

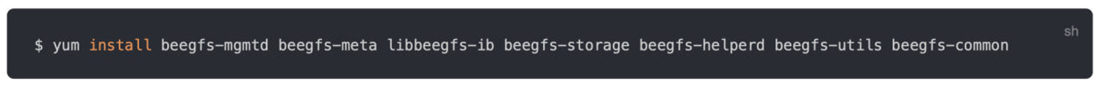

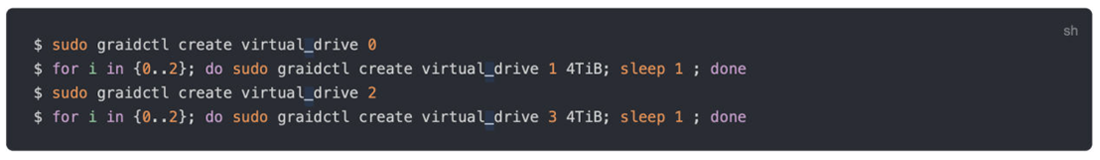

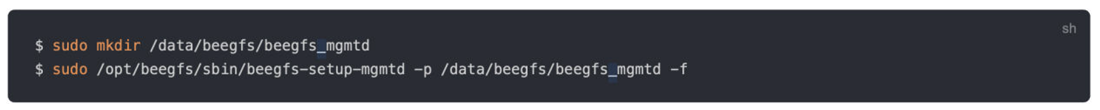

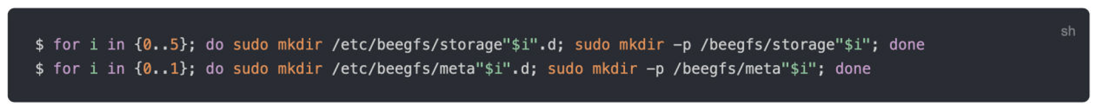

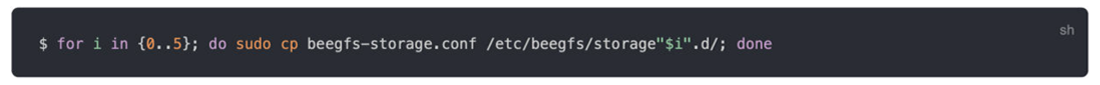

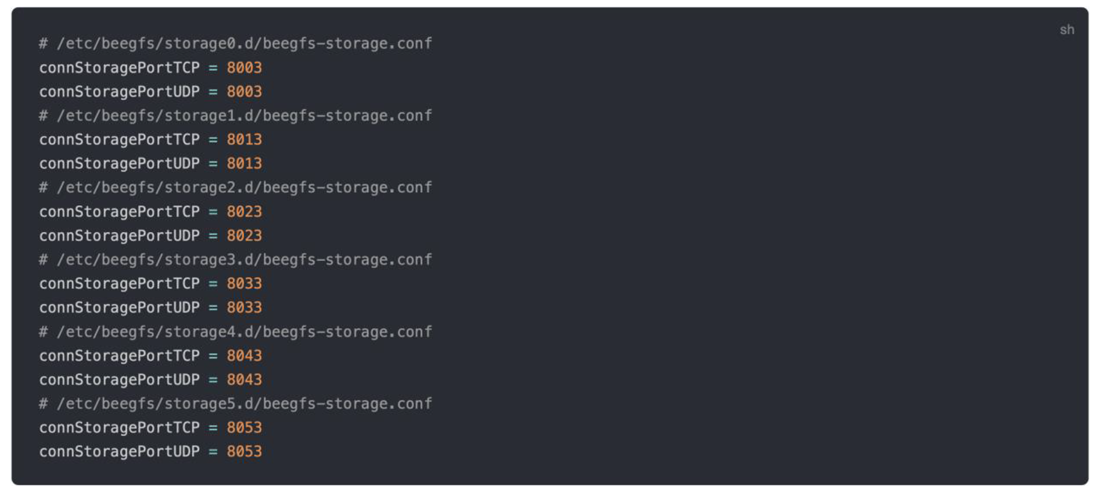

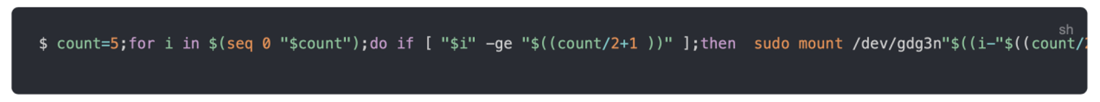

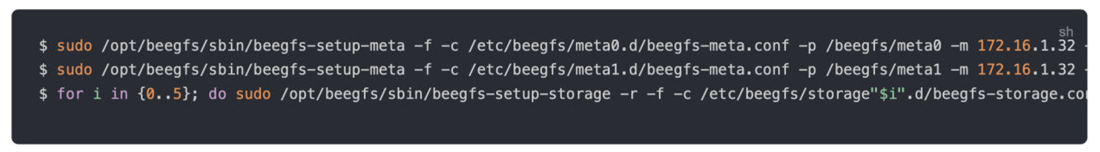

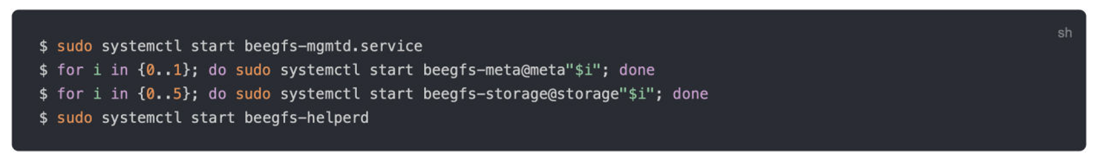

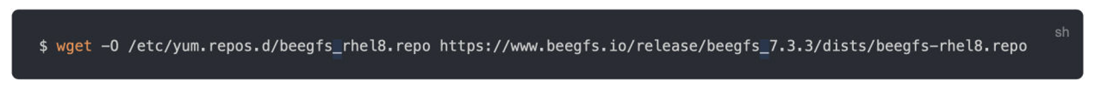

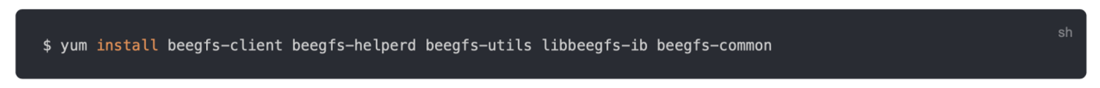

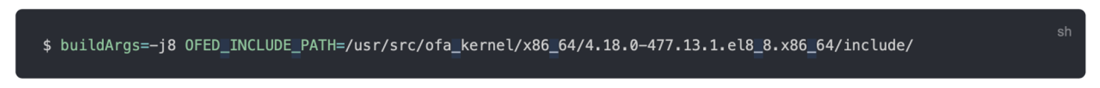

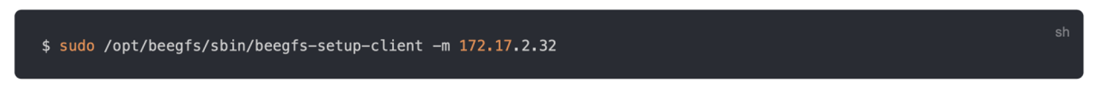

배포 세부정보

소개

SupremeRAID™

BeeGFS 및 StorageBench

IO존

|

|

| 이전글 | |

| 다음글 | [GIGABYTE] 체코 최대 검색 엔진은 GIGABYTE 솔루션을 기반으로 인프라를 구축합니다. |